Trikang

ThermoNeRF: Multimodal Neural Radiance Fields for Thermal Novel View Synthesis 논문 리뷰 본문

ThermoNeRF: Multimodal Neural Radiance Fields for Thermal Novel View Synthesis 논문 리뷰

Trikang 2024. 7. 29. 22:29TMI

- 코드 실행 중 문제가 생겨 문제 수정 후 pull request 보냈는데, 승인되어 해당 논문 코드의 Contributors의 명단에 이름을 올리게 되었다. 간단한 코드 수정을 통해 얻은 결과라 크게 성취감을 느끼진 않지만, 신기해서 공유해본다.

1. Introduction

"NeRFs have also been successfully extended to other sensor modalities"

- Depth views

- Multimodal Neural Radiance Field(2023 ICRA)

- Near-infrared and multi-spectral images

- CrossSpectral Neural Radiance Fields(2022 3DV)

- LiDAR point clouds

- NeRF-LiDAR: Generating Realistic LiDAR Point Clouds with Neural Radiance Fields(2024 AAAI)

- Multimodal Neural Radiance Field(2023 ICRA)

- Audio signals

- Novel-view acoustic synthesis(2023 IEEE/CVF Conference on Computer Vision and Pattern Recognition)

"Moreover, it has been demonstrated that NeRFs can learn from more than a single modality at a time"

- CrossSpectral Neural Radiance Fields(2022 3DV)에서, 근적외선과 RGB 이미지를 결합하여 단일 모달리티를 사용하는 것보다 더 정확한 장면 표현을 학습

- 그러나 multimodal NeRF도 종종 모달리티 간에 두드러지거나 유사한 특징의 존재에 의존함

- NeRFs가 두 가지 이상의 서로 다른 센서 데이터를 결합하여 3D 장면을 재구성할 때, 이러한 데이터들 간에 눈에 띄거나 유사한 특징이 있어야 더 효과적으로 동작한다는 것을 의미하는 것으로 보임

"In this paper, we focus on multimodal NeRF using RGB and thermal imaging."

- Thermal camera는 물체의 온도를 함수로 하여 방출되는 열을 감지함(Thermal cameras capture the radiation emitted by objects as a function of their temperature)

- 우리가 일상적인 온도에서 볼 수 있는 물체들은 중적외선과 원적외선 범위에서 열을 방출함(At ambient temperature ranges, objects radiate in the mid- and far-infrared region of the electromagnetic spectrum).

- 이는 열화상 카메라가 이 범위의 복사(radiation)를 감지하여 온도를 측정하는 원리를 설명

"Since thermal radiation is scattered and reflected from various points within a scene, thermal images naturally lack texture and appear soft"

- with a low edge contrast

- 이를 'ghosting' 현상이라고 함

"such models are primarily constructed using photogrammetry, which requires large amounts of RGB data or advanced equipment"

- Infrared thermography in the built environment: A multi-scale review(2022)

"Moreover, thermal images are often not considered during the geometric reconstruction, and temperature information is projected post-reconstruction[45], leading to potential discrepancies between the model and actual temperatures."

- [45] Thermal point clouds of buildings: A review(2022)

2. Related Work

2.1 Thermal Computer Vision

"Early studies predominantly relied on range measurements—e.g. from LiDAR [31], depth cameras [53, 48] or even a combination of both sensors [8]—to construct 3D models, onto which thermal information was subsequently projected."

- Time-consuming

- Error-prone manual calibration of sensor transformations

- Precision depends on the accuracy of mapping algorithms

- In the case of depth cameras, are limited by their range

"To remove the dependence on range measurements, Maset et al. [39] and De Luis-Ruiz et al. [15] use photogrammetry to construct 3D models from RGB images."

- [39] PHOTOGRAMMETRIC 3D BUILDING RECONSTRUCTION FROM THERMAL IMAGES, 2017

- [15] Generation of 3D Thermal Models for the Analysis of Energy Efficiency in Buildings, 2023

- While these methods achieve high model accuracy, they depend on a dense set of RGB and thermal images

"While previous works presented in this section rely on range or RGB measurements to build the 3D geometry of a scene, Chen et al. [11] and Sentenac et al. [49] used thermal images for 3D reconstruction and temperature estimation."

- [11] 3D Reconstruction from IR Thermal Images and Reprojective Evaluations, 2015

- [49] Automated thermal 3D reconstruction based on a robot equipped with uncalibrated infrared stereovision cameras(2018)

- However, their results are limited to thermal images with high contrast and do not generalize to large structures

2.2 NeRF and Multimodality

"To enhance scene reconstruction, the first multimodal approach incorporated depth data to guide the learning process [16]. However, recent studies have demonstrated that integrating other modalities—e.g. RGB 2D images and LiDAR 3D point clouds [63] or spectral information from filtered RGB inputs [33]—into NeRF can also yield improved scene representations."

- [16] Depth-supervised NeRF: Fewer Views and Faster Training for Free(2021 CVPR)

- [63] Multimodal Neural Radiance Field(2023 IRCA)

- [33] Multi-spectral Neural Radiance Fields(2023)

"Closely related to our work on thermal imaging, Poggi et al. [44] integrates near-infrared and RGB images to create a composite NIR-RGB 3D scene"

- CrossSpectral Neural Radiance Fields(2022 3DV)

- However, NIR images share similar features with RGB images, as they are closer to the visible spectrum compared to thermal images.

"Unlike existing methods that rely on multimodal data with salient visual features, ThermoNeRF combines RGB and thermal features to learn consistent scene geometries across both sensor modalities, while avoiding contamination from each modality in the rendered views."

3. Preliminary

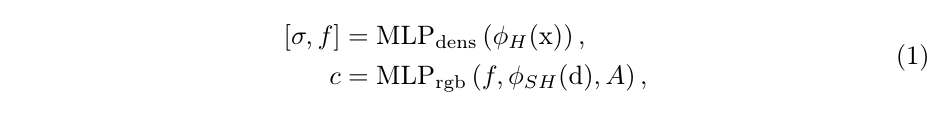

ThermoNeRF는 Nerfacto를 확장하여 Thermal and RGB images를 동시에 재구성하고 새로운 뷰를 합성할 수 있도록 한다. Nerfacto는 여러 최신 모델의 구성 요소를 통합한 NeRF의 최근 확장판으로, MIP-NeRF, MIP-NeRF 360, Instant-NGP, NeRF-W 등이 포함된다.

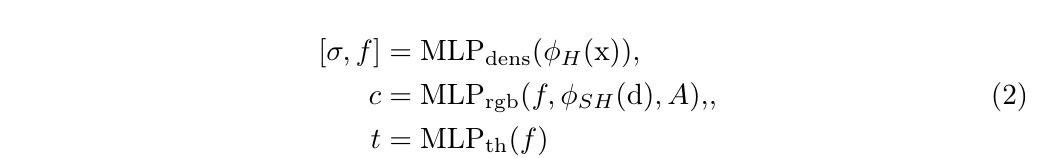

논문에서 NeRF의 MLP에 대해 "NeRF comprises two Multi-Layer Perceptron (MLP) networks: one predicts the density based solely on the 3D location, and the other predicts color based on the 3D location and the viewing direction..." 이라고 언급되어 있는데, 아마도 Instant-NGP에서 따온 모듈을 설명하고 있는 것 같다. 각 MLP가 I-NGP처럼 hidden dimension의 차원이 64인지는 모르겠다.

- f: intermediate features

- c: colors

- φH(): hash encoding

- φSH(): spherical harmonics encoding.

- A: appearance embeddings. 다양한 training view의 exposure, lighting conditions 등을 고려한 이미지 별 임베딩

Sinusoidal-based positional encoding은 positions에 대한 hash encoding, viewing direction에 대한 spherical harmonics로 대체되었다.

4. ThermoNeRF

ThermoNeRF는 RGB, Thermal 이미지의 sparse set으로부터 implicit scene representation을 학습하게 되며, RGB 모달리티가 캡처한 기하학적 특징을 유지하면서 색상 변동과는 독립적인 온도 추정을 보장한다(색상 변동과는 상관없이 온도 추정이 가능하도록 함). 저자들의 디자인 선택(design choices)은 thermal image의 두 가지 속성에 의해 유도된다.

- Thermal image는 본질적으로 부드럽고 텍스쳐가 없다

- 온도는 viewing direction과 독립적이다

Method의 flowchart는 위의 Fig. 2를 참고.

4.1 Thermal Image Rendering

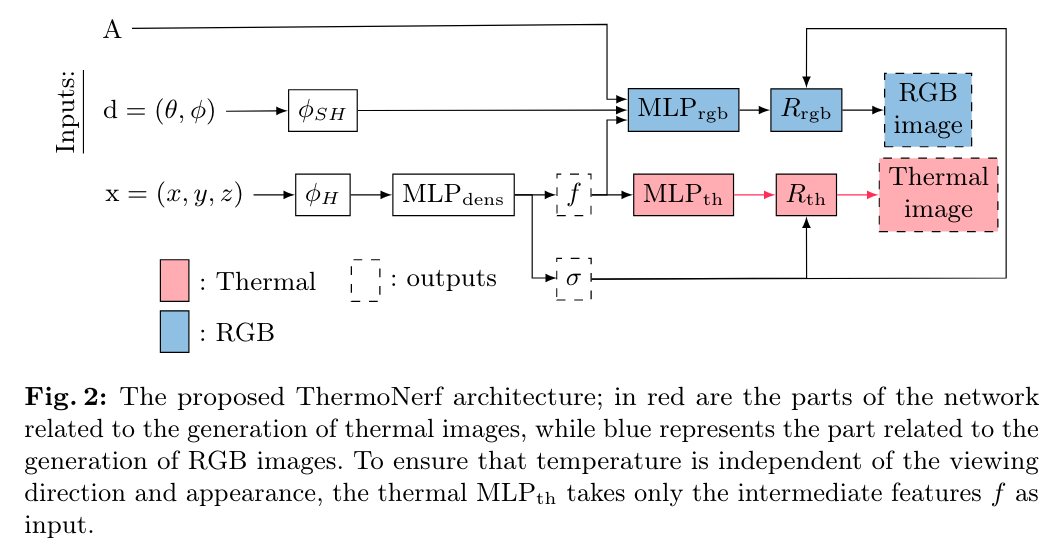

Fig. 3에서 나타난 바와 같이, RGB 정보는 non-Lambertian effect 때문에 view-dependent 할 수 있지만, thermal 카메라는 열 복사를 측정하여 온도로 변환하며 이는 viewing direction과는 무관하다. 따라서 ThemoNeRF는 각 모달리티에 대해 별도의 MLP를 사용한다.

- MLPth: 각 ray를 따라 온도를 예측

- MLPrgb: 각 ray를 따라 RGB 값을 예측

온도는 관찰 방향과 무관하기에, MLPth는 MLPdens의 intermediate feature f만을 입력으로 받지만, MLPrgb는 f, φSH(), A를 입력으로 받는다.

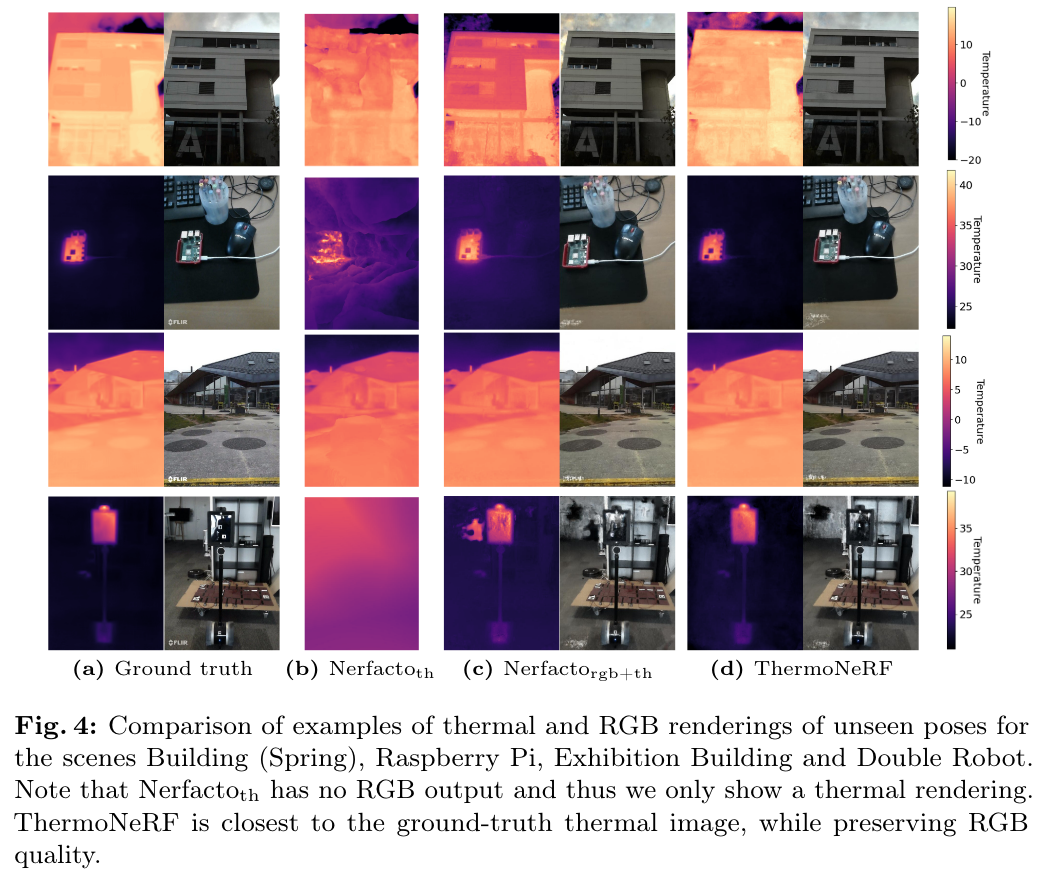

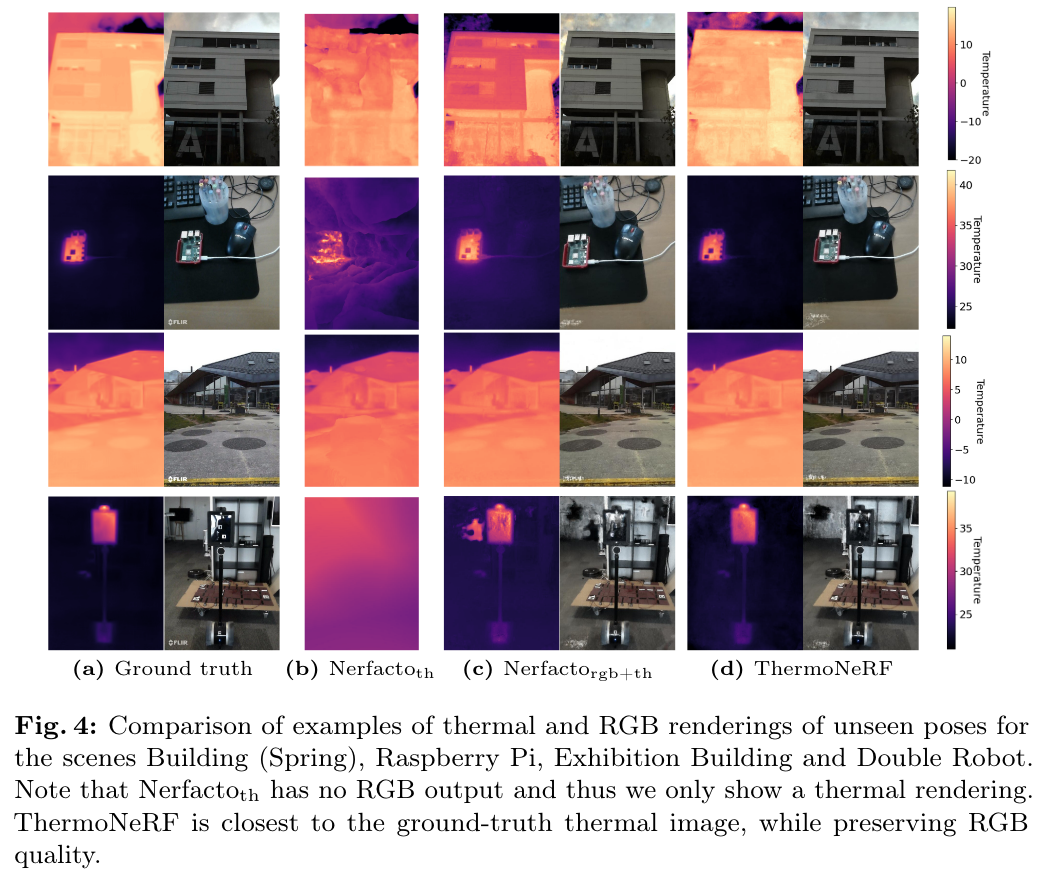

또한, 그림 3의 열 이미지에서 보이는 유령 효과는 열 이미지를 부드럽고 질감 없게 만든다. 따라서 RGB 이미지의 텍스처와 선명한 기하학적 특징(sharp geometric features)은 NeRF 모델이 장면 밀도를 정확하게 추정할 수 있게 하며, thermal 이미지만으로 밀도를 학습하는 데 어려움을 겪는다. - Thermal 이미지 만으로 훈련한 실험 결과는 아래 Fig. 4의 (b)를 참고

따라서 ThermoNeRF에서는 single density NLPdens가 모달리티 간에 공유되어 네트워크가 RGB 정보를 통해 기하학적 표현(geometric representation)을 구성하면서 thermal 모달리티 정보와의 일관성을 유지하도록 함.

논문에는 따로 언급이 없지만, t는 temperatures 인 듯하다.

4.2 Loss Functions

각 모달리티에 대해 분리된 reconstruction loss를 사용한다. 최종 loss는 RGB, thermal 출력에 대한 MSE(Mean Square Error) loss의 합과 와 더불어 MIP-NeRF 360에서 처음 사용된 interlevel loss, distortion loss도 함께 합하여 사용한다(proposal sampler를 최적화하고 왜곡을 줄이기 위한 용도).

5. ThermoScenes Dataset

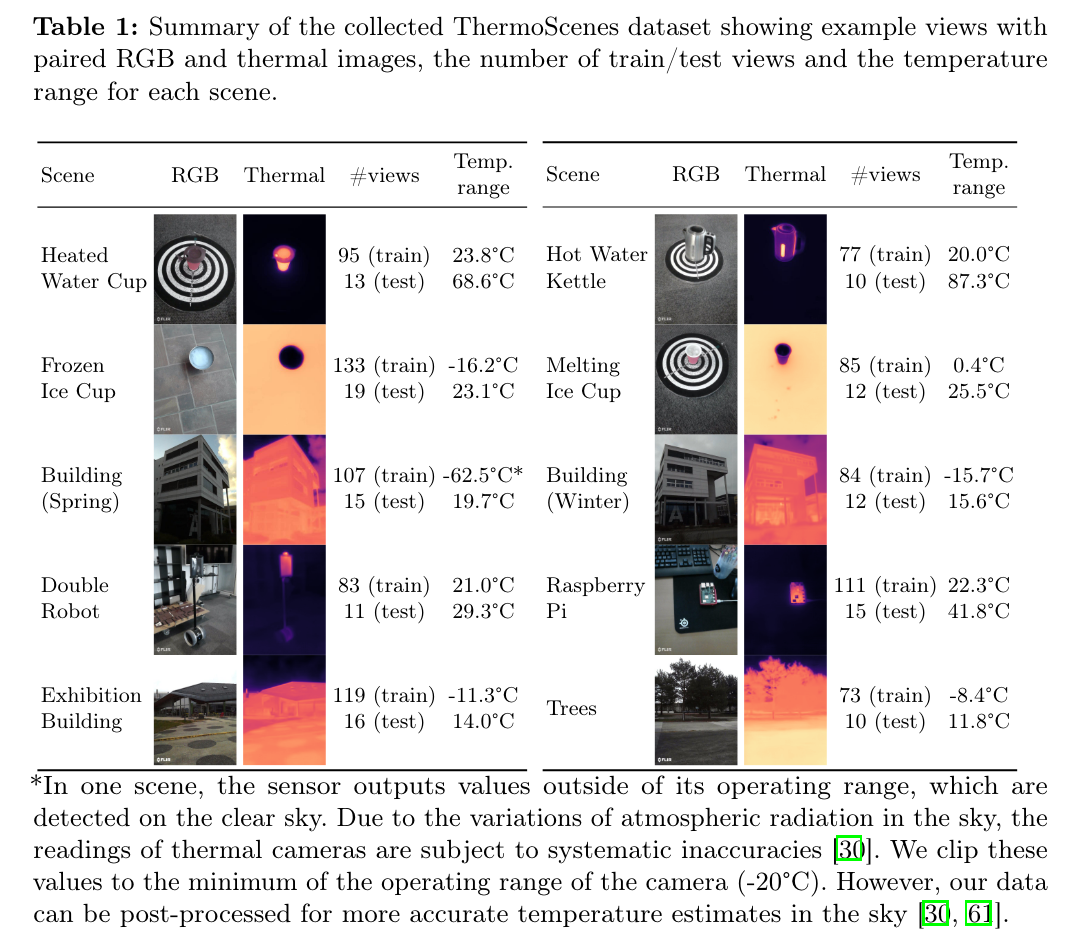

해당 논문에서 새롭게 제안한 ThermoScenes Dataset에는 10개의 scene(4개의 실외, 6개의 실내 데이터)에 대해 RGB and thermal 이미지가 짝을 이루고 있음. 3D thermal reconstruction의 품질을 평가하기 위해서는 thermal accuracy 뿐만 아니라 thermal precision도 이해해야 한다. 저자들은 카메라의 precision을 섭씨 +-0.14도로 평가하는데, 이를 계산하기 위해 고정된 위치에서 라즈베리파이의 연속적인 이미지를 캡쳐하고, 각 픽셀의 온도 표준 편차의 평균(average standard deviation)을 precision으로 삼았다고 한다.

표 1에는 각 장면의 RGB 및 thermal 이미지의 예시 뷰와 ThermoScene 데이터 셋의 요약을 제공한다.

6. Experiments

표 2는 test set의 thermal views synthesis에 대한 per-pixel MAEroi 및 MAE of thermal views synthesis를 보여준다. ThermoNeRF의 평균 MAE가 0.66°C으로, Nerfactorgb+th (1.54°C)와 Nerfactoth (2.89°C)를 크게 능가한다. thermal 이미지로만 훈련된 Nerfacto_th는 정확한 표현을 학습하지 못한다(아래 Fig. 4 참조).

Fig. 5에서는 온도 예측에서 per-pixel absolute error(MAE)를 측정했다. 모든 모델에서 가장자리에서 높은 오차를 관찰할 수 있으며, 이는 열 이미지의 유령 효과로 인해 경계가 흐려지기 때문이다. 체적으로 ThermoNeRF는 가장 적은 오차를 보이며, Nerfactot_h는 왜곡된 재구성으로 인해 가장 나쁜 결과를 보인다. Nerfactorgb+th는 두 모달리티가 단일 MLP에서 최적화되어 RGB 정보로 인해 오차가 높다.

Tab. 3은 RGB 모달리티에서의 성능 비교를 진행한 결과. 표준 Nerfacto가 RGB 입력만으로 훈련된 것과 비교하여 RGB 뷰의 품질 저하가 있는지 확인함. 품질 저하가 거의 없음을 보여주며, Nerfacto와 ThermoNeRF의 RGB에서 PSNR, SSIM, LPIPS의 차이는 각각 -0.49, -0.03, 0.00 이다.

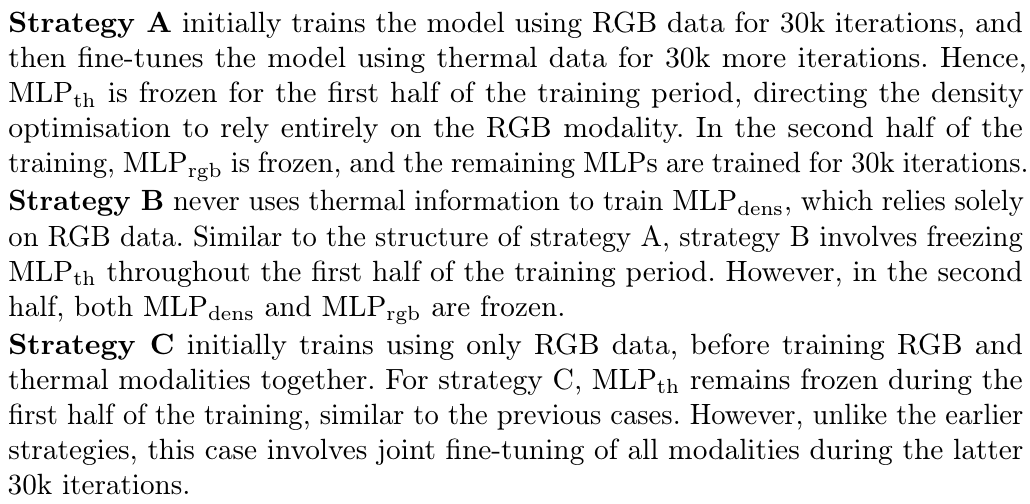

아래는 Ablation study.

7. Conclusion

본 연구에서는 Neural Radiance Fields(NeRF)를 활용하여 새로운 RGB 및 thermal view를 렌더링하는 새로운 multimodal 접근법인 ThermoNeRF를 제안했다. 또한, 저자는 RGB+thermal scene reconstruction을 위해 특별히 설계된 새로운 데이터셋을 수집했다.

thermal 이미지의 텍스처 부재를 보완하기 위해, 저자들의 접근법은 학습 과정 전반에 걸쳐 짝을 이루는 RGB 및 thermal 데이터를 활용한다. scene density는 RGB 및 thermal 입력을 통해 공유 MLP를 통해 효과적으로 학습되며, 색상과 온도 정보는 별도의 네트워크를 통해 추정된다.

저자의 실험 결과는 ThermoNeRF가 thermal 이미지 합성에서 평균 절대 오차 1.5°C를 달성하여, RGB 및 thermal 모달리티를 단순히 결합한 베이스라인보다 50% 이상 향상되었음을 보여준다. 더 나아가, 저자의 multimodal 접근법은 resulting RGB 뷰의 품질에 해를 끼치지 않음을 입증했다. 마지막으로, ablation study를 통해 ThermoNeRF의 fully-joint multimodal training이 여러 대안적인 분리 학습(disjoint training) 전략보다 더 효과적임을 입증했다.

미래 연구의 흥미로운 방향은 ThermoNeRF의 다양한 프레임워크 간 적응성을 탐구하는 것이다(adaptability of ThermoNeRF across different frameworks). 비록 저자의 현재 연구는 Nerfacto에 기반을 두고 있지만, ZIP-NeRF와 같은 최근의 앤티앨리어싱 NeRF 변형과의 호환성을 조사하는 것은 그 유연성과 더 넓은 응용 가능성을 평가하는 흥미로운 기회를 제공한다.

더욱이, 저자들이 제안한 방법의 잠재적 한계는 짝을 이루는 RGB와 thermal 이미지에 의존한다는 점이다. 이러한 짝을 이루는 RGB-thermal 이미지를 수집하는 것은 특히 사용 가능한 하드웨어에 따라 실질적인 도전 과제가 될 수 있다. 저자의 실험에서 사용한 것과 유사한 RGB+thermal 카메라는 접근 가능하고 비용 효율적이지만, 별도의 RGB와 thermal 카메라를 사용하는 경우 이러한 모달리티를 정확하게 정렬하기 위해 신중한 보정이 필요하다. 미래의 연구는 짝을 이루지 않은 RGB와 thermal 이미지 데이터를 사용하여 ThermoNeRF를 훈련할 수 있는 방법을 개발하는 데 초점을 맞출 것이라고 한다.

'공부 > ML' 카테고리의 다른 글

| [Ubuntu 20.04] Ollama 및 GUI 설치하기 (0) | 2025.04.28 |

|---|---|

| 3D Gaussian Splatting - FPS 측정하기 (0) | 2024.11.10 |

| [3D Vision] DUSt3R: Geometric 3D Vision Made Easy 논문 정리 (0) | 2024.07.10 |

| [Camp-ZipNeRF/Troubleshooting] ZipNeRF에 새 데이터 셋 학습 시 체크포인트 저장에서 unexpected keyword argument 에러 발생 (1) | 2024.06.02 |

| [3D Vision/논문 리뷰] EAGLES: Efficient Accelerated 3D Gaussians with Lightweight EncodingS (1) | 2024.06.02 |